1、定义交叉熵是衡量两个概率分布之间差异的一种工具,常被用作损失函数来源交叉熵源于编码理论中的最佳编码成本概念,通过衡量使用一个分布的代码发送消息到另一个分布时的平均长度来定义本质与意义本质交叉熵反映了使用一个分布的代码来表示另一个分布的信息时所需的最小平均码字长度,即信息。

2、交叉熵损失函数的意义和作用如下交叉熵Cross Entropy是Shannon信息论中一个重要概念,主要用于度量两个概率分布间的差异性信息语言模型的性能通常用交叉熵和复杂度perplexity来衡量交叉熵的意义是用该模型对文本识别的难度,或者从压缩的角度来看,每个词平均要用几个位来编码复杂度的意义是。

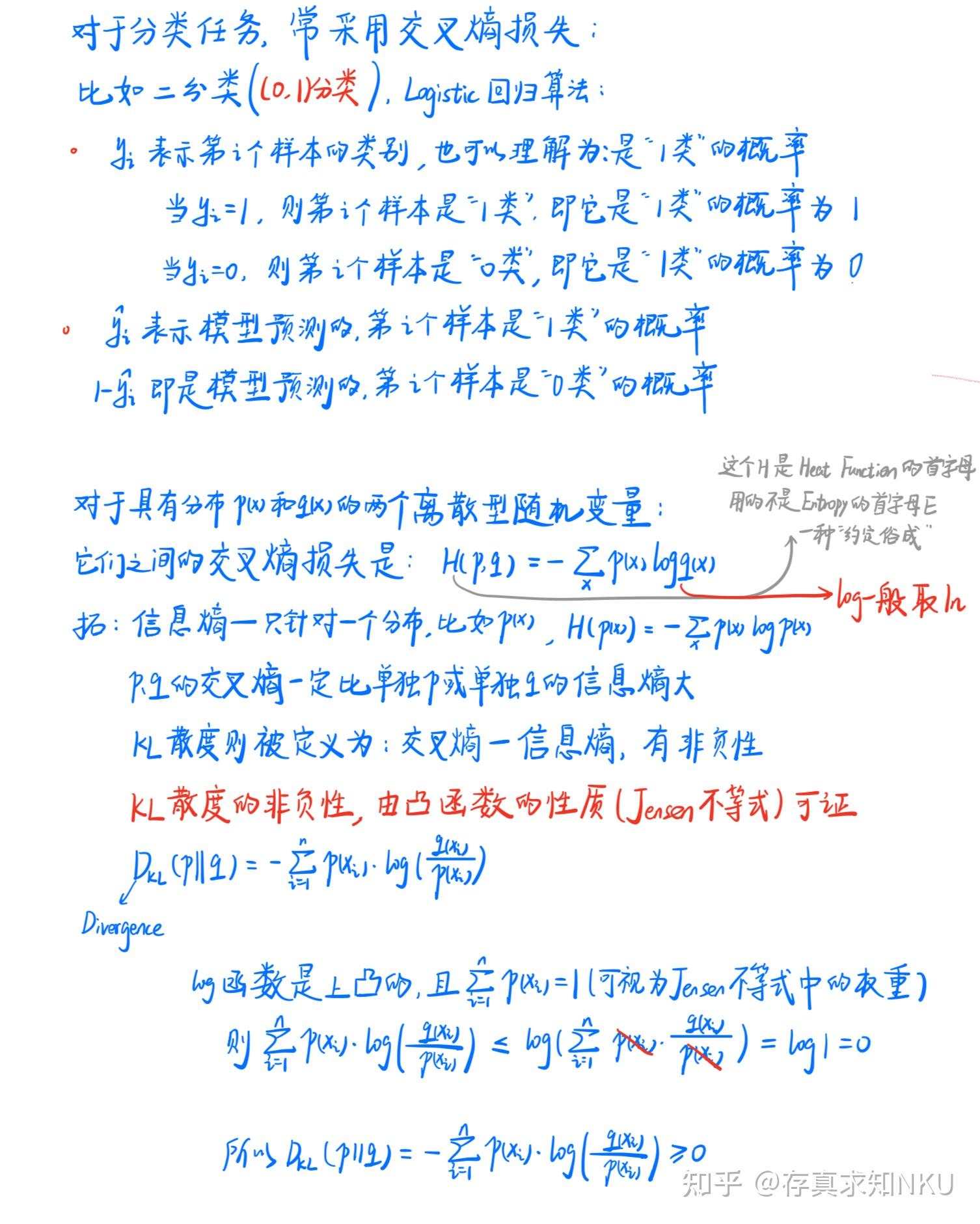

3、交叉熵损失函数在机器学习中扮演核心角色,用于度量真实概率分布与预测概率分布之间的差异,其值越小,表示模型预测效果越好以二分类交叉熵为例,具体公式如下\Loss = 121*log07 + 1*log02\在此公式中,X表示样本等于特定类别的概率向量,Y为样本的标签,此例中Y为1,0,计算交。

4、总之,交叉熵损失函数是评估模型性能优化分类任务的关键工具理解其原理与应用,对于提升模型效果具有重要意义。

5、定义在多分类任务中,交叉熵损失函数用于衡量预测概率分布与实际标签分布之间的差异作用通过计算预测输出与期望输出之间的距离,帮助网络进行参数优化Softmax回归当神经网络的输出不是概率分布时,使用Softmax回归将其转换为概率形式,以便与期望概率进行比较TensorFlow实现。

6、交叉熵表达式与相对熵相似,但相对熵中第一项Hpp为固定值,作为常量存在在模型训练过程中,样本标签已知,相当于真实分布px已知,常量Hpp可以忽略因此,交叉熵损失函数成为评估模型性能的有效工具在二分类问题中,逻辑回归是一种常见的应用通过预测两个类别的概率,逻辑回归同样采用二分类交叉熵。

7、那我们就可以引入损失函数,且令 Loss = log Pyx即可则得到损失函数为 非常简单,我们已经推导出了单个样本的损失函数,是如果是计算 N 个样本的总的损失函数,只要将 N 个 Loss 叠加起来就可以了 这样,我们已经完整地实现了交叉熵损失函数的推导过程 可能会有读者说,我已经知道了交叉熵损失函数的。

8、交叉熵损失函数是一种用于衡量模型预测概率分布与真实概率分布之间的差异的方法交叉熵损失函数在机器学习和深度学习中被广泛应用,尤其在分类问题中它是评估分类模型性能的一种常用指标交叉熵损失函数的本质在于衡量两个概率分布之间的差异在机器学习中,我们通常关心模型预测的概率分布与真实概率分布。

9、公式为公式交叉熵简化了KL散度的使用,定义为公式交叉熵损失的计算方法基于单个样本,真实分布为公式,网络输出分布为 公式,总类别数为n计算公式为公式通过交叉熵损失函数,模型能优化预测分布,使其更贴近真实数据分布,从而在分类任务中提高预测准确性。

10、交叉熵损失基于极大似然估计,适用于样本满足独立性和伯努利分布的情况在二分类问题中,交叉熵损失函数是衡量预测概率与实际标签之间差异的有效方式BCEWithLogitsLossPyTorch推荐使用的一种损失函数,内置sigmoid函数以保持数值稳定性,适用于二分类问题的输出层多分类问题中的损失函数交叉熵损失。

11、交叉熵在机器学习和信息理论中都有着重要的意义交叉熵是衡量两个概率分布之间差异的一种方法,特别在机器学习和深度学习中,它常常被用作损失函数衡量预测与实际差距在分类任务中,交叉熵能够衡量模型预测的概率分布与真实的概率分布之间的差异优化目标通过最小化交叉熵损失,可以使得模型的预测。

12、在深度学习领域,损失函数是评估模型预测结果与实际结果之间的差距,进而指导模型调整参数以提高预测准确性的关键组成部分两种常用的损失函数分别是均方差损失函数MSE和交叉熵损失函数Crossentropy下面,我们将从概念原因和优化问题的角度出发,对比分析MSE和Crossentropy的异同概念区别 均方差。

13、\Hp, q = \sum_x px \log qx\交叉熵在机器学习中的应用,如softmax_cross_entropy,是用于评估预测概率分布 \q\ 与真实分布 \p\ 之间的差距在实际应用中,对于二分类问题,通常使用binary_cross_entropy作为损失函数总结而言,交叉熵函数在机器学习中用于评估模型预测。

14、深度学习领域中,损失函数是评估模型性能的关键工具,PyTorch中的nnCrossEntropyLoss便是其中一种广泛应用的损失函数它专门设计用于多分类问题,能有效计算模型输出与真实标签之间的交叉熵损失nnCrossEntropyLoss函数的核心参数包括无权重大小平均忽略索引可选择的减少和还原模式,以及标签平滑。

15、其定义基于熵相互熵KL散度与交叉熵三个概念交叉熵被视为相互熵的特例,其中p表示真实概率分布,q为预测概率分布以二分类问题为例,交叉熵损失函数由两部分组成,分别对应0类和1类的概率分布由于p0=1p1,从而得到二分类交叉熵损失函数的表达式交叉熵损失函数的理论基础源于信息论。

16、因此,引入交叉熵损失函数来解决分类问题成为了一个更优的选择交叉熵损失函数不仅能够有效衡量模型预测的准确性,还具备凸函数的性质,便于求导找到全局最优解在多分类问题中,交叉熵损失函数通过计算每个类别的预测概率与真实标签之间的差异来实现,该函数在二分类和多分类情况下的表达式有所不同在。

17、其中,公式表示样本i属于第j类的概率,公式表示属于,公式表示不属于交叉熵损失函数的实际意义是通过正确的标签来惩罚模型预测结果,其本质是度量两个概率分布之间的距离预测值与真实值一致时,损失函数趋近于0反之,损失函数增大Python实现在TensorFlow 2x版本中,可以使用。