搜索引擎的工作原理包括如下三个过程首先在互联中发现搜集网页信息同时对信息进行提取和组织建立索引库再由检索器根据用户输入的查询关键字,在索引库中快速检出文档,进行文档与查询的相关度评价,对将要输出的结果进行排序,并将查询结果返回给用户1抓取网页每个独立的搜索引擎都有自己的网页;互联网信息爆炸增长,搜索引擎抓取系统负责搜集保存更新信息,为用户提供有效资源百度蜘蛛Baiduspider作为抓取系统的重要组成部分,遍历网络,维护URL库和页面库,确保信息更新抓取系统框架包括链接存储选取DNS解析调度分析提取链接分析存储等模块,Baiduspider通过此系统高效完成互联网页面;搜索引擎抓取原理 搜索引擎的处理对象是互联网网页,日前网页数量以百亿计,所以搜索引擎首先面临的问题就是如何能够设计出高效的下载系统,以将如此海量的网页数据传送到本地,在本地形成互联网网页的镜像备份下面是我整理的搜索引擎抓取原理,希望对你有帮助!搜索引擎工作的第一大特点就是爬行抓取,就;上文讨论了百度搜索引擎的工作原理,包括蜘蛛抓取系统的基本框架百度蜘蛛的主要抓取策略类型抓取过程中涉及的网络协议抓取频次原则及调整方法造成抓取异常的原因新链接重要程度判断百度优先建重要库的原则哪些网页无法建入索引库搜索引擎索引系统概述倒排索引的重要过程影响搜索结果排序的因素;搜索引擎的工作原理主要就是四个步骤爬行,抓取,检索,显示搜索引擎放出蜘蛛在互联网上爬行,目的是为了发现新的网站和最新的网页内容,从而经过搜索引擎特定程序分析后决定是否抓取这些信息,抓取后然后将其放到索引数据库中,顾客在搜索引擎网站上检索信息时,就会在结果页上出现与检索词相关的信息,并。

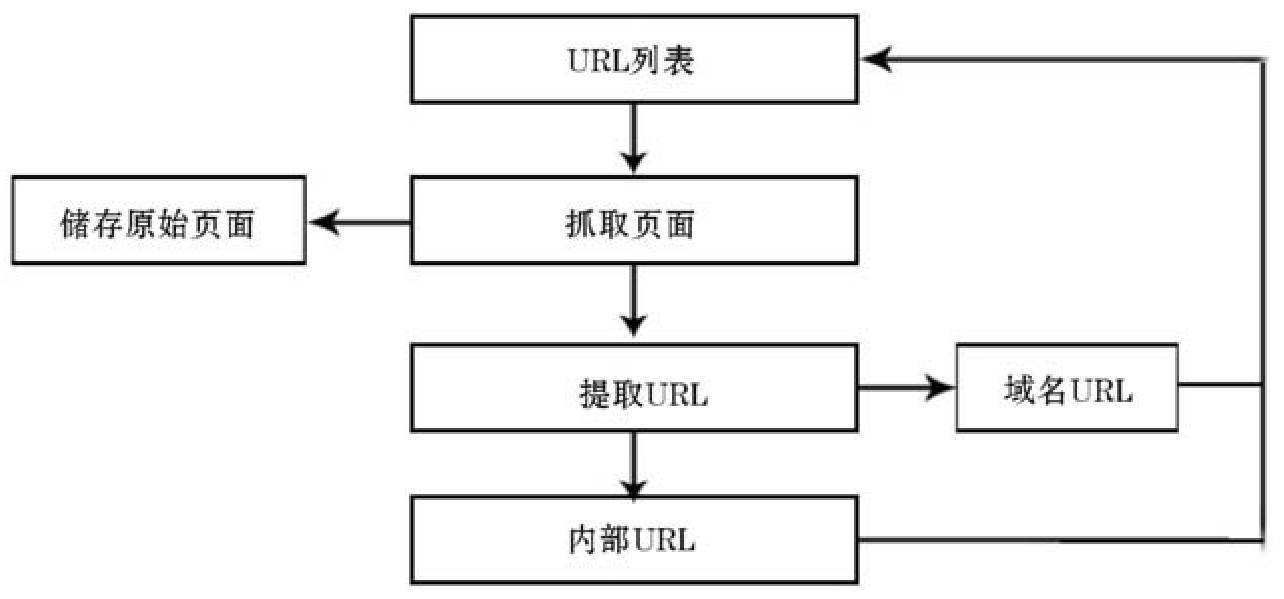

1抓取 读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来,被抓取的网页被称之为网页快照2数据库处理 搜索引擎抓;一爬虫 搜索引擎爬取网页内容的工具就是爬虫爬虫通过网络请求获取网页数据,并进行解析处理,以便后续存储和检索二URL管理 在爬虫开始工作前,需要先确定要抓取的URL地址URL管理会根据一定规则生成一系列URL地址,并将其放入待抓取队列中,供爬虫依次进行抓取三页面下载 当一个网页被加入待;实际上,搜索引擎内部有一个网址索引库蜘蛛从搜索引擎的服务器出发,顺着已知的网址爬行并抓取网页内容抓取回来的页面会被分析,内容被暂时忽略,而链接则被提取出来这些链接并不会立即被蜘蛛抓取,而是被记录并交给网址索引库进行进一步分析对比和计算,最终放入索引库因此,即便某个网页的外链出现;百度“蜘蛛”实则是采集器,尽管其工作原理看似简单,但其技术含量并不低作为全球最大的华文搜索引擎,百度需要面对数百万个华文网站,而每个网站的内页数量更是如同天上的繁星从科学角度来看,百度“蜘蛛”可以视为一种半自动工具,它能够逐步进化,变得越来越智能,能够自动判断采集到的页面内容是否有;它的工作原理类似于您计算机上的搜索框,您输入关键词后,立刻就能得到结果百度蜘蛛则是通过搜索引擎系统的计算,来决定对哪些网站施行抓取,以及抓取的内容和频率计算过程会参考网站的历史表现,包括内容是否足够优质是否存在对用户不友好的设置是否存在过度的搜索引擎优化行为等当网站产生新内容时。

本文将深入剖析百度搜索引擎的工作原理,让你对排名规则有更深入的理解首先,理解搜索引擎的工作机制是SEO学习的基础,毕竟SEO的目标是优化对搜索引擎的友好度搜索引擎主要由几个关键模块组成抓取模块搜索引擎的核心任务之一是抓取互联网上的网页蜘蛛程序,如百度蜘蛛,负责自动抓取网页并存储到数据;搜索引擎是互联网上不可或缺的工具,它帮助用户找到所需的信息搜索引擎的工作原理大致分为三个阶段抓取网页处理网页以及提供检索服务首先,搜索引擎使用网页抓取程序spider来抓取互联网上的网页这些抓取程序会顺着网页中的超链接,连续地抓取网页被抓取的网页会被保存为“网页快照”理论上;百度蜘蛛作为百度搜索引擎的一部分,负责抓取互联网上的网页图片视频等内容,并将其整理归类,建立索引数据库,以便用户在百度搜索引擎中找到所需信息百度蜘蛛的工作流程大致分为两个阶段下载阶段和处理阶段在下载阶段,蜘蛛会抓取网页,并将这些网页存储在补充数据区,这一区域的数据是不稳定的;搜索引擎命令它到互联网上浏览网页,从而得到互联网的大部分数据因为还有一部分暗网,他是很难抓取到的然后把这些数据存到搜索引擎自己的数据库中自己发帖或者外推产生的URL如果没有搜索引擎蜘蛛爬行,那么该搜索引擎就不会收录该页面,更不用说排名了r 而蜘蛛池程序的原理,就是将进入变量模板生成;百度属于全文搜索引擎百度属于全文搜索引擎,这意味着它使用一种算法来搜索和分析网页中的文本内容,以寻找与用户搜索查询相关的信息全文搜索引擎的工作原理是通过爬取互联网上的网页,收集其中的文本信息,并建立索引以供用户搜索当用户在百度上输入搜索查询时,百度会使用其算法分析搜索查询中的关键词。

搜索引擎的工作原理总共有四步第一步爬行,搜索引擎是通过一种特定规律的软件跟踪网页的链接,从一个链接爬到另外一个链 接,所以称为爬行第二步抓取存储,搜索引擎是通过蜘蛛跟踪链接爬行到网页,并将爬行的数据存入原始页面数据库第三步预处理,搜索引擎将蜘蛛抓取回来的页面,进行各种步骤;百度搜索引擎的工作原理涉及数据抓取系统的关键作用,它就像一个网络蜘蛛,从重要的种子URL开始,通过超链接不断发现新页面,确保数据来源的稳定和全面抓取系统主要由链接存储选取DNS解析调度分析和存储等组件构成,以高效友好且智能的方式抓取网页,维护URL库和页面库Baiduspider的设计策略复杂。