问题原因服务器上的cuda版本过低,无法满足深度学习需求因此,卸载了cuda,但也意外地卸载了显卡驱动,现在需要重新安装显卡驱动解决问题1确认内核版本和发行版本 可以看到服务器是CentOS Linux 79的通过lspci命令查看Linux服务器上是否有可用的GPU显卡可以看到有两个nvidia的V100 GPU2;第2名峰会Summit美国最快的超级计算机Summit的性能得分维持在1488 Pflops它由4,356个节点组成,每个节点配备两个Power9 CPU,每个CPU含有22个内核以及六个Nvidia Tesla V100 GPU每个GPU都有80个流式多处理器这些节点通过Mellanox双轨EDR InfiniBand网络连接该系统由IBM建造,位于田纳西州。

测试配置包括 V100 32GB PCIe *2CUDA 120NVIDIA 驱动 52512506 和 PyTorch通过 PyTorch 的 Benchmark 测试浮点运算性能机器无法手动调整 GPU 频率测试结果显示,半精度单精度和双精度测试结果与理论值有差距,实测性能低于理论值 2687%567% 和 347%五Transformer+WMT’14;4060 Ti的起售价大约三千多元,性价比各有千秋不同的GPU针对不同的场景有着不同的优化,例如RTX 4060利用TensorRT可显著提升性能最后,云计算服务提供商如阿里云提供了GPU云服务器,如V100的定价在月租方面,16GB版本的优惠价为每月7640元起对于经常需要高性能计算的用户,长期租赁可能更为划算。

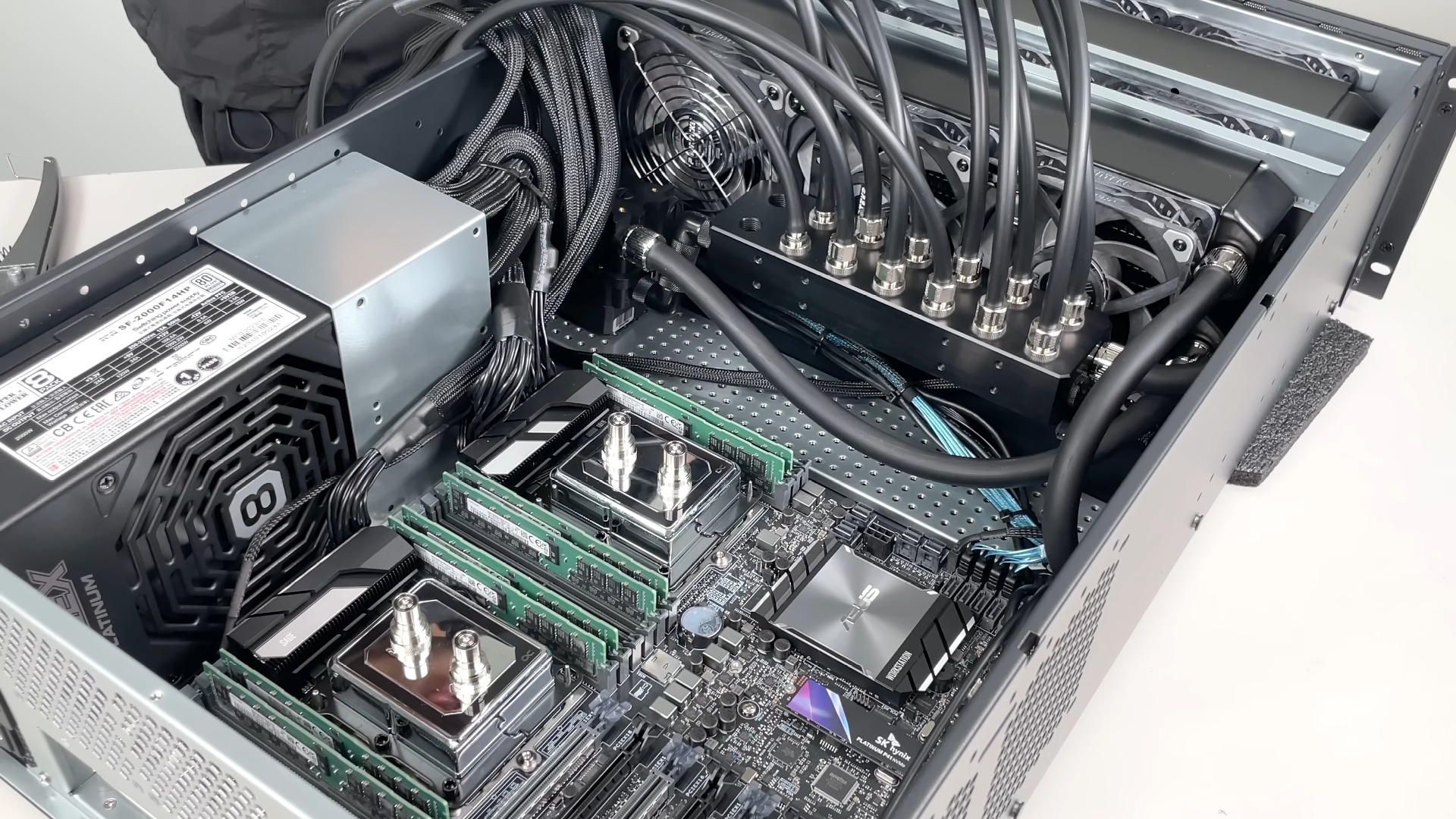

NVIDIA推出强化版GPU服务器DGX2H,与前代DGX2一样,搭载16颗提升功耗的Tesla V100 GPU,性能跃升显著Tesla V100作为业界最强GPU,凭借12nm工艺815平方毫米的超大晶圆,集成210亿晶体管,集成5120个FP32核心2560个FP64核心和640个Tensor核心,搭配32GB HBM2显存相较于DGX1的8卡配置和双路;以下是我觉得性价比高的几款GPU云服务器供参考腾讯云提供配置为8核40G内存搭载英伟达v100 GPU芯片的GPU计算型GN10Xp服务器v100专为高计算密集型HPCAI和图形处理任务设计,性能卓越每月价格5340元,支持续期,便于随时暂停使用,通过腾讯云镜像功能,省去重新配置环境的繁琐腾讯云的GPU计算型GN7。

A100 V100显卡的选购与主板服务器搭配需考虑以下几点首先,注意显卡特性A100 V100显卡不具备显示输出接口,需要额外的亮机卡或具备核显的平台被动散热设计意味着依赖机箱风扇散热,需谨慎考虑散热环境其次,考虑硬件适配显卡形态分为PCIE与SXM,需根据具体收到的形态适配主板推荐至强可扩展三代或;NVIDIA GPU 技术显著提升了必优科技UTalkDoc文档智能体的性能,通过TensorRTLLM加速指令识别模型,以及Triton推理服务器在V100 GPU上的部署,UTalkDoc的用户指令识别服务效率得到了显著提升吞吐量翻了5倍,单个请求响应时间缩短了三分之一,这不仅优化了服务运行效率,还提高了资源利用率NVIDIA技术帮助。

选择最好的GPU服务器需要考虑以下因素GPU性能GPU性能是选择GPU服务器的最重要因素你需要找到具有最新GPU芯片和高性能的服务器,这将直接影响计算速度和任务处理时间例如,NVIDIA Tesla V100和A100 GPU都是目前最强大的GPU芯片内存容量GPU服务器的内存容量越大,可以处理的数据就越多,从而提高。

NVLink技术的引入,如第二代的25 Gbs速度6个链接和300 GBs带宽,使得GPU间通信更快且更高效HBM2内存的16 GB容量,提供900 GBs的峰值带宽和15倍的效率提升,ECC支持增强了数据可靠性NVIDIA的DGX1系统整合了这些先进技术,构建了高性能服务器,如NVLink技术Power 9 CPU和Tesla V100;选择GPU服务器时首先要考虑业务需求来选择适合的GPU型号在HPC高性能计算中还需要根据精度来选择,比如有的高性能计算需要双精度,这时如果使用P40或者P4就不合适,只能使用V100或者P100同时也会对显存容量有要求,比如石油或石化勘探类的计算应用对显存要求比较高还有些对总线标准有要求,因此选择GPU型。

选择GPU服务器时首先要考虑业务需求来选择适合的GPU型号在HPC高性能计算中还需要根据精度来选择,比如有的高性能计算需要双精度,这时如果使用P40或者P4就不合适,只能使用V100或者P100同时也会对显存容量有要求,比如石油或石化勘探类的计算应用对显存要求比较高还有些对总线标准有要求,因此,十次方;2英伟达的DGX A100单台算力就能够高达5 Peta Flops,拥有超高的计算密度性能和灵活性,确实很适合做人工智能等开发,上海世纪互联的GPU服务好像就是首款基于A100所构建的AI系统,可以去了解一下3DGXA100 AI 是世界上第一台单节点 AI 算力达到 5 PFLOPS 的服务器 ,每台 DGX A100 可以分割为。

V100,作为Volta架构的代表,具备5120个CUDA核心与16GB到32GB的HBM2显存,支持Tensor Cores加速器,能显著提升深度学习性能A100,采用Ampere架构,拥有更高性能的6912个CUDA核心与40GB的HBM2显存,集成第二代NVLink技术,实现GPU到GPU的高速通信,提升大型模型训练效率在大模型训练场景中,V100与A100展现出;英伟达凭借其在人工智能芯片领域的优势,先后推出了V100A100H100等多款用于深度学习训练的GPUV100,作为Volta架构的代表,具备5120个CUDA核心与16GB到32GB的HBM2显存,支持Tensor Cores加速器,能显著提升深度学习性能A100,采用Ampere架构,拥有更高性能的6912个CUDA核心与40GB的HBM2显存,集成第二代。

在深度学习场景中,GPU服务器是必不可少的一部分,也是可以提高计算速度和精度的关键,以下是几种适合深度学习场景的GPU服务器1 NVIDIA Tesla V100 服务器具备高性能计算能力和内存容量,适用于深度学习大规模数据分析和AI训练等场景2 AMD Radeon Instinct MI60 Server可用于机器学习高性能;对于推理阶段的多GPU利用,注意这种方法仅适用于API部署或模型分片,但可能导致速度减慢,具体效果需自行测试在训练阶段,有几种多GPU的使用方法可供选择利用torch自带的分布式,通过torch run代替直接的python命令 使用Huggingface提供的Accelerate启动器,可以简化配置 微软的deepspeed启动器提供了深度。