1、交叉熵损失函数在机器学习中扮演核心角色,用于度量真实概率分布与预测概率分布之间的差异,其值越小,表示模型预测效果越好以二分类交叉熵为例,具体公式如下\Loss = 121*log07 + 1*log02\在此公式中,X表示样本等于特定类别的概率向量,Y为样本的标签,此例中Y为1,0,计算交叉熵损失对于多分类问题。

2、在二分类问题中,交叉熵损失函数的公式可以表示为Loss = 1n * Σ + * log,其中n为样本数量,y_i为样本i的真实标签,p_i为样本i的预测概率在多分类问题中,交叉熵损失函数的公式可以表示为Loss = 1n * Σ,其中M为类别总数,i表示第i个样本,yic表示第i个样本类别c的标签。

3、以图片分类问题为例,假设选取一张图片输入网络,得到一个包含多个预测概率的一维张量若图片真实类别已知,将其转换为独热编码形式通过交叉熵损失函数计算真实分布与预测分布之间的差异,得到损失值模型训练与优化神经网络的训练过程即对每个数据进行预测计算损失更新权重不断减小损失,直至在训练。

4、具体公式为假设每个样本有n个类别,第i个样本的真实类别标签为yi,模型输出的logits为logits,其中logitsj表示该样本在第j个类别上的输出分数交叉熵损失计算如下对于带权重的情况,每个类别的权重weightj会被考虑,总损失公式为sum weightj * loglogitsj ,其中j是真实类别。

5、损失计算在单分类问题中,每张图片的损失是单个交叉熵而在多分类问题中,损失则是所有类别交叉熵之和 参数调整通过计算神经网络输出的得分与标签的交叉熵,梯度下降法会根据模型的错误程度调整参数,速度在模型效果差时较快,在效果好时变慢三优点与缺点 优点交叉熵损失函数在大类数场景下。

6、+ log$$其中,$N$ 是样本数量,$y_i$ 是第 $i$ 个样本的真实标签,$p_i$ 是模型预测的第 $i$ 个样本为正类的概率对于多分类问题,交叉熵损失函数则是对每个类别的概率进行加权求和综上所述,交叉熵是衡量两个概率分布之间差异的重要指标,在机器学习和深度学习中具有广泛的应用。

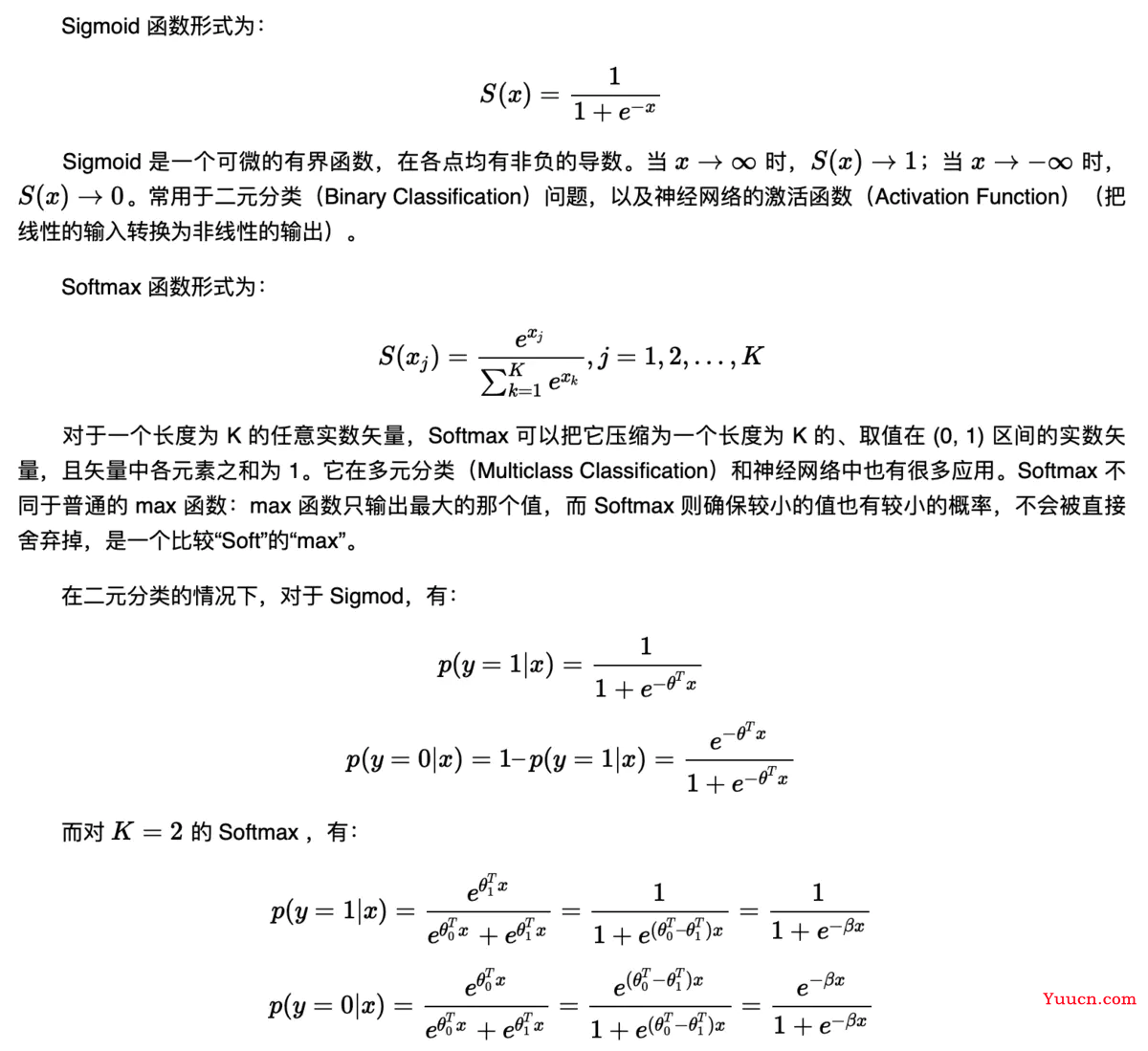

7、交叉熵损失通常与sigmoid或softmax函数结合使用神经网络输出的logits经过sigmoid或softmax转换后,得到每个类别的概率分布这些概率分布与真实类别的一维onehot向量相结合,通过计算得出最终的损失值优势交叉熵损失函数是凸函数,这确保了全局最优解的搜索它具有高效的学习能力,能够快速调整模型权重。

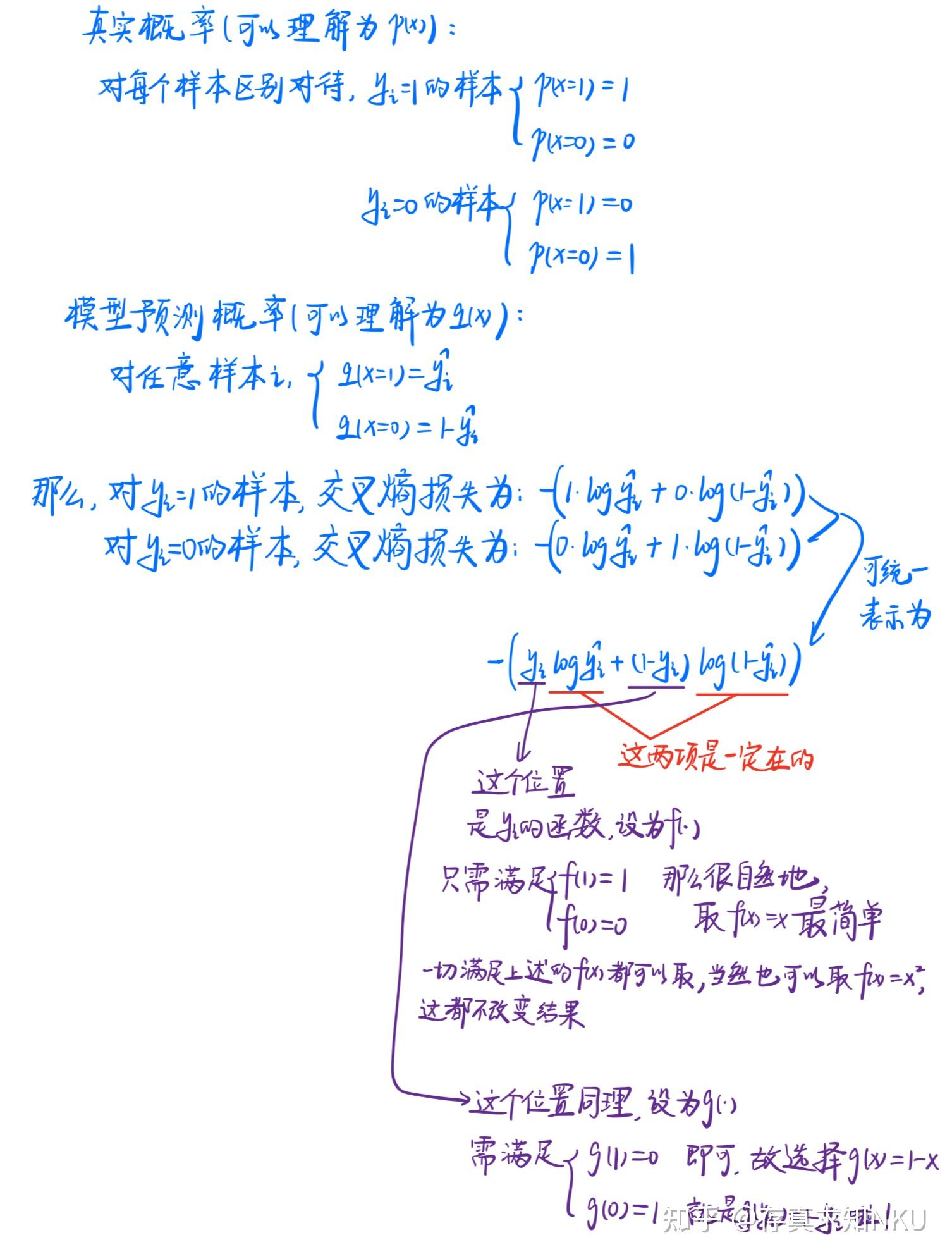

8、交叉熵函数旨在最大化样本属于其真实值的概率当真实值为1时,如果预测值p接近1,则损失函数值较小如果预测值p接近0,则损失函数值较大当真实值为0时,如果预测值p接近0,则损失函数值较小如果预测值p接近1,则损失函数值较大数学逻辑可以从数理统计的极大似然估计出发理解在给定样本。

9、那我们就可以引入损失函数,且令 Loss = log Pyx即可则得到损失函数为 非常简单,我们已经推导出了单个样本的损失函数,是如果是计算 N 个样本的总的损失函数,只要将 N 个 Loss 叠加起来就可以了 这样,我们已经完整地实现了交叉熵损失函数的推导过程 可能会有读者说,我已经知道了交叉熵损失函数的。

10、这种调整通过log函数的非线性性质实现,鼓励模型输出更接近真实标签的概率值图形表示在图形上,交叉熵损失函数随预测值的变化而变化预测值与真实标签的距离越大,损失函数的值越高,表示模型受到的“惩罚”也越大这种直观的表示方式有助于我们理解模型预测的准确性以及如何进行优化适用场景交叉熵。

11、在预测概率分布中,只有一类的概率为1,其他类概率为0因此,准确预测意味着该类别的概率接近1,而其他类的概率接近0在使用PyTorch框架实现深度学习模型时,可以通过函数直接计算交叉熵损失PyTorch中计算Cross Entropy损失函数时,注意Python数组从0开始索引,因此类别索引从0开始。

12、二分类在二分类问题中,交叉熵损失函数计算的是预测为正类的概率与真实标签之间的对数损失多分类在多分类问题中,交叉熵损失函数计算的是预测概率分布与真实标签之间的对数损失之和与相对熵的关系交叉熵与相对熵紧密相连KL散度衡量的是两个概率分布之间的差异,而交叉熵在训练过程中可以被看作。

13、反向传播过程用于计算损失函数对模型参数的梯度,以便更新参数以减少损失在计算梯度时,需要利用链式法则,结合softmax函数和交叉熵函数的特性,计算出每个权重参数的梯度通过梯度下降或更高效的优化算法,模型参数会逐渐调整,使得预测结果更接近实际标签以上内容详细解释了软最大函数和交叉熵函数在神经。

14、真实标签与预测概率分布之间的差异可以通过交叉熵损失函数来衡量其计算公式为交叉熵损失函数值越小,表示真实标签与预测概率分布越接近在四分类任务中,真实标签和预测概率分布的差异可以通过交叉熵损失函数计算得出通过反向传播方法调整模型权重,可以最小化损失函数,提高预测准确率。

15、对于sigmoid函数结合交叉熵损失函数 权重梯度推导交叉熵损失函数对权重的偏导数与误差值正相关具体来说,梯度表达式中包含预测值与目标值之间的差异,当这个差异较大时,梯度值也较大,从而加快权重更新速度这表明,在误差较大的情况下,模型能更快地调整权重以减小误差 偏置梯度推导与权重梯度。

16、逻辑回归的交叉熵损失函数原理,是面试中的常见问题交叉熵函数,作为对数损失函数,其形式为公式这里的公式代表真实值0或1,公式代表预测值估计值概率范围0~1,大于05判定为1,小于05判定为0直观理解,交叉熵函数旨在最大化样本属于其真实值的概率交叉熵损失函数的数学。

17、PyTorch中的实现PyTorch中的CrossEntropyLoss函数自动处理softmax和标签计算,但理解其背后的逻辑至关重要批处理在实际训练中,通常处理一批数据以提高效率,而非单个样本手动实现交叉熵损失函数步骤需要对预测数据进行softmax处理,然后根据交叉熵的计算公式求得每个样本的损失,再求平均值示例。