神经网络中采用交叉熵作为损失函数,以克服sigmoid函数在梯度更新上的问题sigmoid函数导数饱和导致梯度更新效率降低,即斜率较小,这影响了学习过程的速度交叉熵损失函数在计算梯度时避免了梯度弥散现象,使得学习速率更加稳定相关理论和证明显示,交叉熵与sigmoid函数的导数无关,有效防止了梯度消失,提升了。

交叉熵损失通常与sigmoid或softmax函数结合使用神经网络输出的logits经过sigmoid或softmax转换后,得到每个类别的概率分布这些概率分布与真实类别的一维onehot向量相结合,通过计算得出最终的损失值优势交叉熵损失函数是凸函数,这确保了全局最优解的搜索它具有高效的学习能力,能够快速调整模型权重。

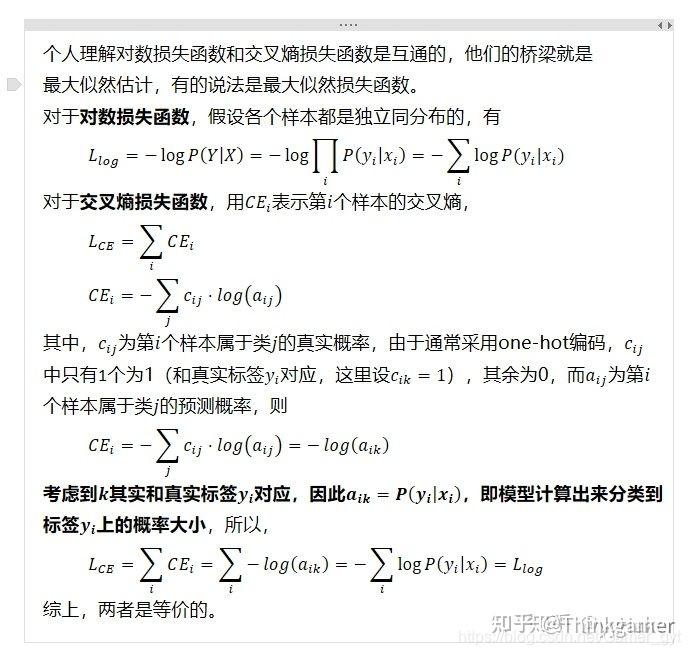

定义交叉熵是信息论中的概念,常用于图像分类中的损失函数,如二分类和多分类任务作用衡量预测分布与真实分布之间的差异在深度学习中,优化的目标通常是降低交叉熵,以减小预测值与真实标签的差距L1 Loss适用场景适用于回归任务,尤其是对抗离群点的影响特点在处理异常值时比L2 Loss更。

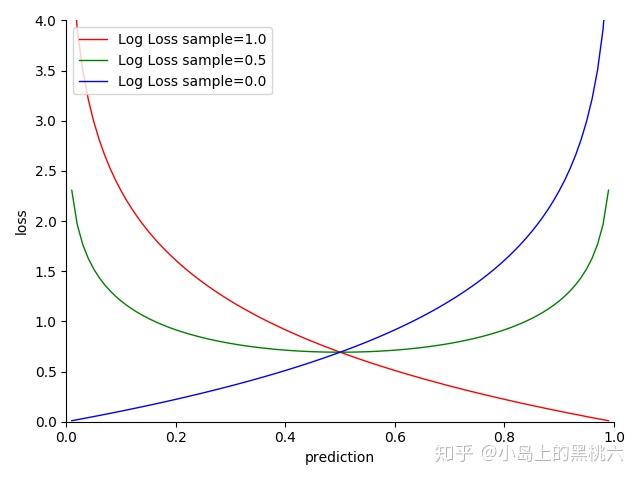

在梯度下降学习过程中,交叉熵损失函数能够使模型在表现不佳时学习速度较快,而在表现良好时适当放缓这种自适应的学习速率调整机制保证了模型的学习效率与sigmoidsoftmax配合时效果显著当交叉熵损失函数与sigmoid或softmax激活函数配合使用时,能够显著提升分类任务的性能这是因为这两种激活函数能够将。

sigmoid函数与均方差损失函数在优化权重和偏置时存在缺陷,即在输出接近0和1时,梯度接近于0,导致学习速度变慢为解决这一问题,交叉熵损失函数被广泛用于分类问题,其梯度与误差值正相关,误差越大,学习速度越快接下来,我们通过sigmoid和softmax函数的分析,探讨交叉熵损失函数在权重和偏置梯度推导中。

总结无论是sigmoid函数还是softmax函数,结合交叉熵损失函数都能有效地优化模型在面临大误差时,模型能更快地调整权重和偏置,从而加快学习速度这使得交叉熵损失函数成为分类任务中的理想选择。