1、为了避免决策树模型的过拟合现象,通过修枝操作调整模型复杂度修枝方法包括预修枝与后修枝,预修枝在模型构建前设定最大深度或最小样本量,后修枝在充分构建模型后,根据模型错误率进行修剪常用决策树算法包括C45C50CHAIDCART和QUEST在回归决策树中,目标变量为连续数值型通过计算Gini指标熵或分类误差等准则,选择最优划分。

2、决策树法的步骤1 收集数据并预处理2 选择决策树的算法3 构建决策树模型4 评估和优化决策树模型5 应用决策树模型进行预测或分类接下来进行 1 收集数据并预处理在这一步中,需要收集与问题相关的数据,并对数据进行清洗和预处理,以便输入到决策树模型中数据预处理包括数据清理。

3、利用 ID3 算法构建决策树是一种有效的方法,尤其在面对复杂决策时首先,从信息量最大的条件开始推断结果,能够以最少的步骤达到目的在构建决策树时,通过量化信息量,使用信息熵作为度量工具,来选择最佳分叉点信息熵定义为集合中正反例的比例,通过公式 EntropyS = p+log2p+ plog2。

4、决策树极其容易过拟合,一般需要通过剪枝,缩小树结构规模缓解过拟合剪枝技术有前剪枝和后剪枝两种有些算法用剪枝过程,有些没有,如ID3预剪枝对每个结点划分前先进行估计,若当前结点的划分不能带来决策树的泛化性能的提升,则停止划分,并标记为叶结点后剪枝现从训练集生成一棵完整的决策。

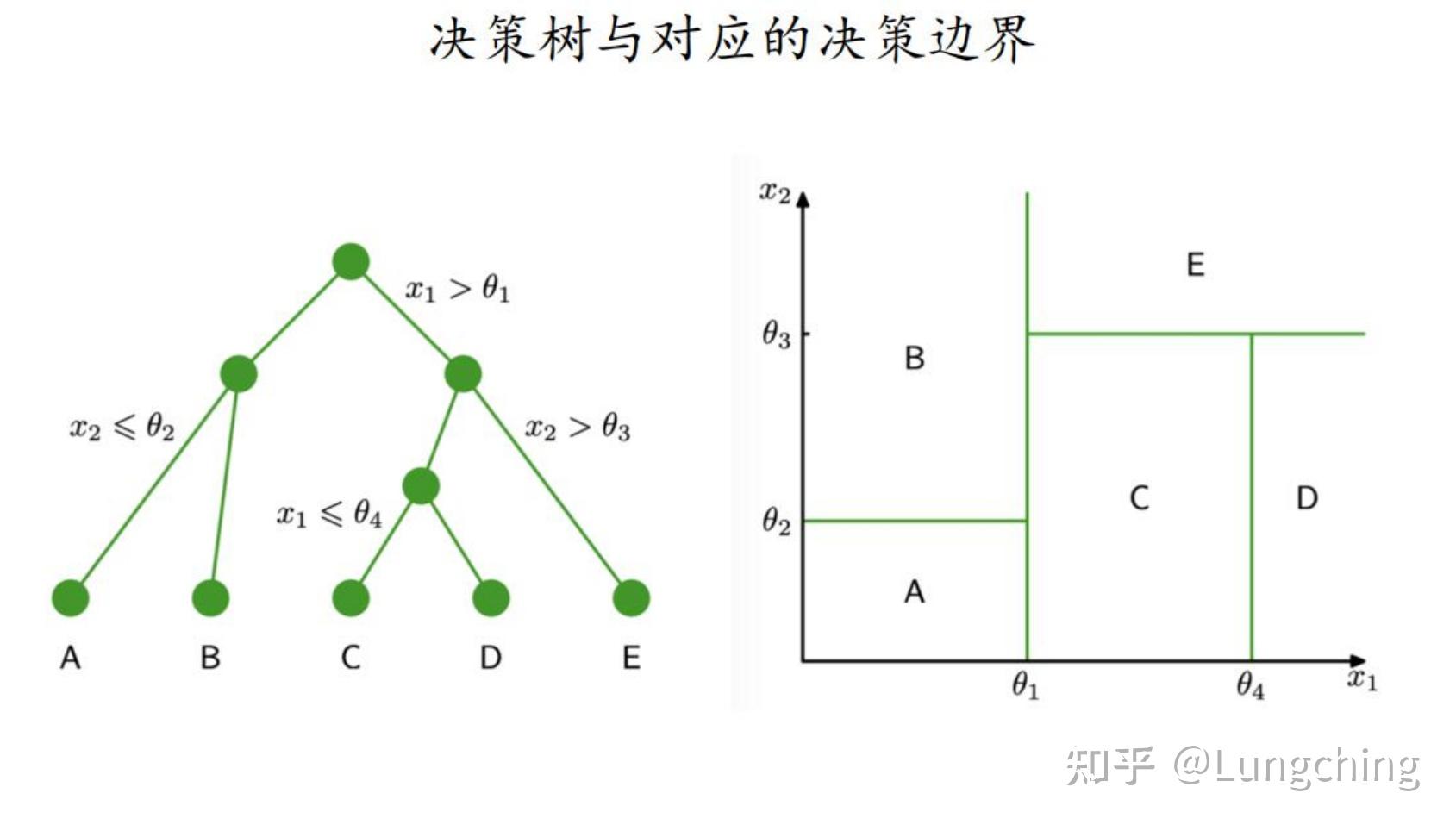

5、决策树学习通常包括三个步骤 特征选择 决策树的生成 和 决策树的修剪 #x2003#x2003分类决策树模型是一种描述对实例进行分类的树形结构,决策树由节点node和有向边directed edge组成节点有两种类型内部节点internal node和叶节点leaf node内部节点表示一个特征或属性,叶节点表示一个类 #x2003#x2003。

6、fromsklearnimporttree#导入需要的模块clf=treeDecisionTreeClassifier#实例化clf=clffitx_train,y_train#用训练集数据训练模型result=clfscorex_test,y_test#导入测试集,从接口中调用需要的信息二重要参数21criterion决策树需要找出最佳节点和最佳的分枝方法,对分类树来说,衡量这个quot最佳。

7、决策树是一种预测模型,为让其有着良好的预测能力,因此通常需要将数据分为两组,分别是训练数据和测试数据训练数据用于建立模型使用,即建立特征组合与标签之间的对应关系,得到这样的对应关系后模型后,然后使用测试数据用来验证当前模型的优劣通常情况下,训练数据和测试数据的比例通常为91,82。

8、那些算法能够实现决策树#160 #160 在决策树构建过程中,什么是比较重要的特征选择按照熵变计算,算法产生最重要的部分,决策树中叶节点的分类比较纯,节点顺序的排列规则熵变数据的预处理改进思路一般有两个1,换算法2,调参数 做好数据的预处理1,做好特征选择2,做好数据。

9、决策树部分图例决策树的优缺点以及改进 优点缺点改进集成学习方法 集成学习通过建立几个模型组合的来解决单一预测问题它的工作原理是 生成多个分类器模型 ,各自独立地学习和作出预测这些预测最后结合成单预测,因此优于任何一个单分类的做出预测随机森林是一个包含多个决策树的分类器,并且。

10、对上述表的训练集数据,利用ID3算法建立决策树解 第一次迭代 特征有自己的房子将数据集 划分为2个子集 有自己的房子和 没有自己的房子,观察一下 和 由于 所有实例都属于同一类 ,所以它是一个叶结点,结点的类标记为“是”对于 则需从特征 中选择新。

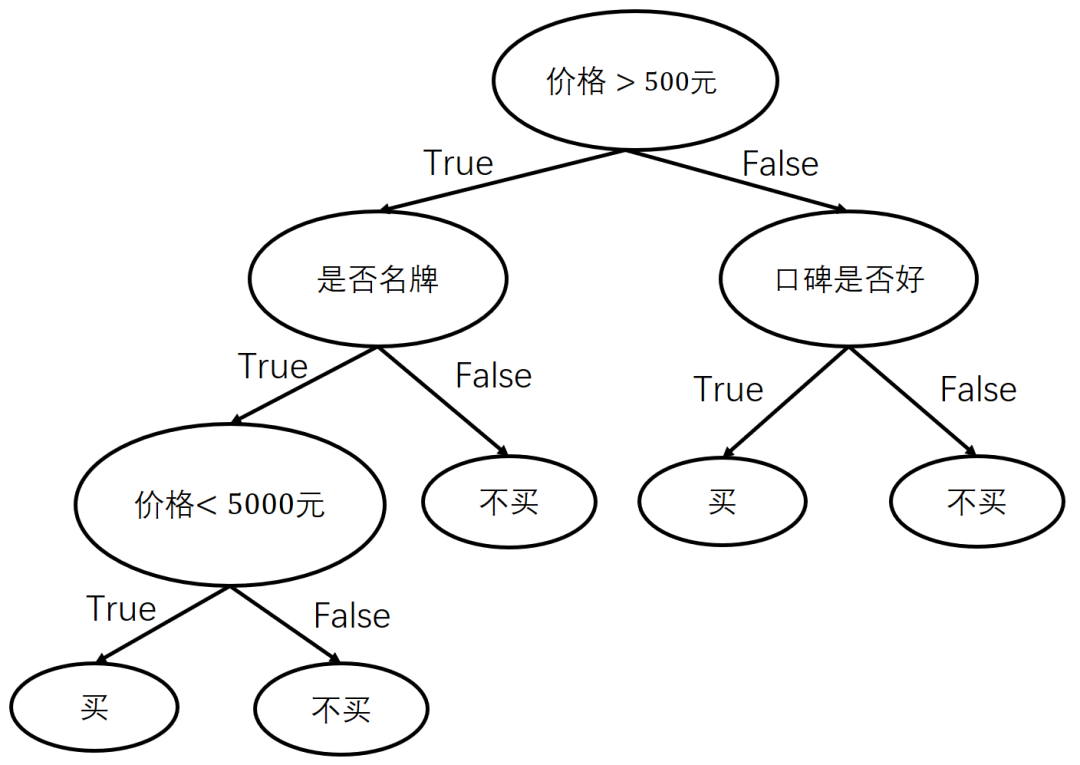

11、画决策树的步骤如下A先画一个方框作为出发点,又称决策节点B从出发点向右引出若干条直线,这些直线叫做方案枝C在每个方案枝的末端画一个圆圈,这个圆圈称为概率分叉点,或自然状态点D从自然状态点引出代表各自然状态的分枝,称为概率分枝E如果问题只需要一级决策,则概率分枝末端画三角形,表示终点 例题假设。

12、R语言之决策树和随机森林总结决策树之前先总结一下特征的生成和选择,因为决策树就是一种内嵌型的特征选择过程,它的特征选择和算法是融合 R语言之决策树和随机森林总结决策树之前先总结一下特征的生成和选择,因为决策树就是一种内嵌型的特征选择过程,它的特征选择和算法是融合 展开。

13、CART算法由以下两步组成1决策树生成基于训练数据集生成决策树,生成的决策树要尽量大2决策树剪枝用验证数据集对己生成的树进行剪枝并选择最优子树,这时用损失函数最小作为剪枝的标准主要优点模型具有可读性,分类速度快学习时,利用训练数据,根据损失函数最小化的原则建立决策树。

14、其核心在于通过自助法重采样技术,从原始训练集中有放回地随机抽取样本,生成多个决策树通过集合方式,随机森林提高了单个决策树的分类性能,同时降低过拟合风险,增强抗噪能力具体实现步骤包括从样本集中随机有放回抽取n个样本,从所有特征中随机选择k个特征建立决策树,重复此步骤生成m棵树,形成随机。

15、节点的划分的过程也就是树的建立过程,每划分一次,随即确定划分单元对应的输出,也就多了一个结点当根据相应的约束条件终止划分的时候,最终每个单元的输出也就确定了,输出也就是叶结点这看似和分类树差不多,实则有很大的区别划分点的寻找和输出值的确定是回归决策树的两个核心问题 一个。

16、决策树作为有监督算法的一种,以其直观的决策过程易于理解和解释的特点,在分类和回归任务中表现突出决策树的训练与测试过程涉及到对数据进行特征选择建立决策规则评估模型性能等关键步骤在建立决策树的关键中,决策树的构建过程依赖于特征选择准则,而信息增益是衡量特征选择的重要指标之一具体来。

17、定义流失周期数据获取与处理建立决策树模型用户流失预警 用户流失周期的确定采用回访率回访用户数流失用户数* 100%作为判定指标即在定义流失周期内没有访问行为后再度访问网站或APP的用户借助用户回访率这一指标可以不断的修正用户流失周期长度的判定用户流失周期越长,用户的访问率。