何凯明团队提出的Focal Loss针对样本不平衡问题,通过降低易分样本的损失,将焦点放在难分样本上Focal Loss的参数调整对分割效果至关重要,特别是取值为公式时,损失函数会优先关注正难样本然而,Focal Loss在分割任务上的适用性通常限于二分类情况Dice Loss和IOU Loss作为metric learning方法,可用;二分类交叉熵损失公式为fx是模型预测类别为y的概率多分类交叉熵损失函数的公式稍微复杂,涉及对每个类别的概率计算sigmoid损失函数使用交叉熵损失而不是平方损失,因为交叉熵在误差较大时梯度较大,有助于快速收敛,而误差小时梯度较小,可得到较好的最优解Focal损失是加权的二分类交叉熵损失;Log Loss常用于二分类问题,衡量预测概率与实际标签之间的差异Cross Entropy Loss是Log Loss的推广,适用于多分类问题,常与SoftMax激活函数一起使用正则项L1正则项通过剪裁参数来控制模型复杂性,倾向于产生稀疏解L2正则项通过权重衰减来控制模型复杂性,提供平滑的权重分布分类损失函数。

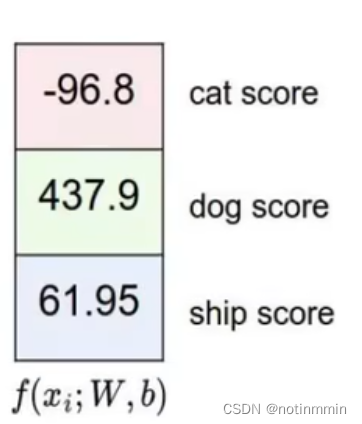

例如,目标设置为全为1的向量,预测为15,权重同样全为1,BCEWithLogitsLoss计算结果为tensor02014二元交叉熵损失函数binary_cross_entropy和带logits的版本binary_cross_entropy_with_logits区别在于,后者的损失函数内部自带了计算logit的操作,无需额外使用sigmoidsoftmax将网络输入映射至;在计算机视觉的语义分割中,常用的损失函数有以下几种交叉熵损失定义最常见的损失函数,利用对数函数的单调性衡量预测值与真实值之间的差异特点预测值越接近真实值,反向传播中的权重更新越慢但可能对背景像素的影响过大,导致前景预测不准确加权二元交叉熵定义通过手动为不同类别赋予权重;计算神经网络每次迭代的前向计算结果与真实值的差距根据查询损失函数加入权重相关信息资料得知,作用是计算神经网络每次迭代的前向计算结果与真实值的差距损失函数是用来估量你模型的预测值fx与真实值Y的不一致程度,它是一个非负实值函数。

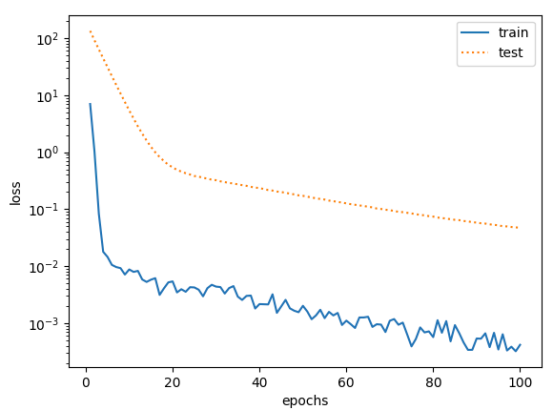

MultiLabelMarginLoss用于多标签分类,MultiLabelSoftMarginLoss是SoftMarginLoss的多标签版本,CosineEmbeddingLoss用于计算向量之间的余弦距离,TripletMarginLoss用于计算三元组损失,CTCLoss连接主义时间分类用于解决时序数据分类问题在PyTorch中实现带有权重的BCE损失函数,主要步骤包括定义损失函数对象计算;计算原理Hinge损失函数主要用于支持向量机解决分类问题它通过优化目标函数,找到最优的权重向量和偏置项,使得训练集上的损失函数最小化Python实现可以通过NumPy库实现,使用npmaximum计算单个样本的损失,然后求平均得到整体损失值三余弦相似度损失函数 计算原理余弦相似度损失函数用于计算模型;1 对比损失 对比损失,最早在CVPR 2006提出的Dimensionality Reduction by Learning an Invariant Mapping中被提出它将输入的两个样本通过相同的编码器转换成编码表示,然后优化相同类样本之间的距离尽可能小,不同类样本之间的距离尽可能大该损失函数为后来的表示学习损失函数奠定了基础,通过对比机制确保;选择依据任务类型损失函数的选择依赖于具体的任务类型,如线性回归问题通常选择MSE,而分类问题则选择交叉熵等模型性能不同的损失函数对模型的稳定性和精度有不同的影响,因此需要根据实际需求选择合适的损失函数优化过程迭代调整在训练过程中,优化函数会根据损失函数的值迭代调整模型的权重,以;然而,在实际应用中,当负样本数量庞大时,损失函数倾向于优化易分类样本,而非我们希望优化的难分类样本为解决这一问题,引入了Focal LossFocal Loss针对负样本数量过多的问题进行了改进它通过引入一个系数α来控制正负样本的权重,使得模型在优化过程中更加关注难分类样本同时,Focal Loss利用两个;损失函数包括三种类型01损失函数绝对损失函数平方损失函数和对数损失函数它们分别衡量输出与期望值之间的差异,帮助优化模型预测算法应用 神经网络学习过程中,损失函数用于调节权重,使预测值更接近实际值类比减肥,通过调整饮食与运动的权重,实现体重目标误差反向传播算法作为经典方法,通过迭代。

对泛化性能有影响 Perceptron损失函数简化版Hinge,对判定正确性要求高 交叉熵损失函数多分类和二分类问题,考虑置信度 权重交叉熵损失针对样本不平衡,增加调整参数难度 Focal Loss解决类别不平衡,增强对正样本的关注 回归损失 均方差损失L2 Loss,常用,收敛快但对;深入探讨torch的NLLLoss用法,此函数用于评估模型输出的对数概率和实际标签之间的差异首先,创建模型时设置模型的损失函数为NLLLoss,可以提供权重参数,如weight=C,例如在二分类任务中,仅存在正例和负例两类,可设置weight参数进行调整在真正计算损失时,通过调用modelloss_funcinput, target;描述Hinge损失的简化版,对正确分类样本的判界距离无严格要求特点简化了模型交叉熵损失函数描述描述模型预测值与真实值差距,适合二分类和多分类任务优点能有效解决权重更新速度问题与最大似然函数关系交叉熵函数与最大似然函数有密切联系,通过最小化交叉熵实现对数似然函数的最大化。

其计算方式如式1所示,其中$\alpha$为预测概率,$g$为调节权重因子的超参数具体而言,Focal Loss通过系数因子$\alpha#39 = \alpha^1\gamma$来调整样本权重,其中$\gamma$是调节参数,控制了损失函数对容易样本与困难样本的关注程度当预测概率$\alpha$接近1时,即预测结果与真实标签高度;本文支持的损失函数如以下图片所示欢迎大家订阅我的专栏,一起学习YOLO专栏目录YOLOv5改进有效涨点目录,包括卷积主干检测头注意力机制Neck等上百种创新机制二原理介绍 SlideLoss的原理主要来源于YOLOFaceV2通过权重函数解决简单样本和困难样本之间的不平衡问题简单样本和困难样本如何。